Data Mining et Machine Learning

John Samuel

CPE Lyon

Année: 2024-2025

Courriel: john.samuel@cpe.fr

.jpg)

.png)

La construction de caractéristiques est une étape essentielle dans le pipeline de prétraitement des données en apprentissage machine, car elle peut aider à rendre les données plus informatives pour les algorithmes d'apprentissage.

Cette formalisation est au cœur de l'apprentissage supervisé, où l'objectif est d'apprendre à partir d'exemples étiquetés et de trouver une fonction qui puisse prédire de manière précise les étiquettes pour de nouvelles données non vues.

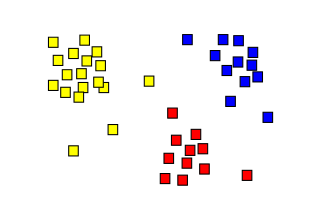

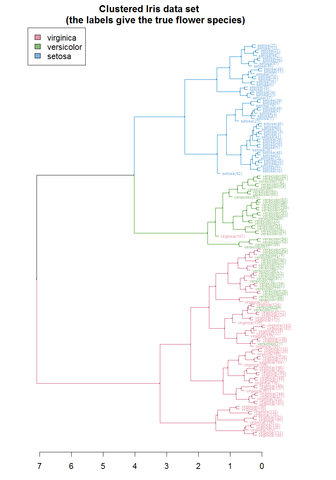

L'apprentissage non supervisé est utilisé pour explorer et découvrir des modèles, des structures ou des caractéristiques inhérentes aux données, sans l'utilisation d'étiquettes ou de labels préalables. Il est couramment utilisé dans des domaines tels que la clustering, l'analyse de composantes principales (PCA), l'analyse en composantes indépendantes (ICA), et bien d'autres.

Dans le contexte de la classification en apprentissage machine, l'évaluation des performances d'un modèle implique la compréhension de différents types de prédictions qu'il peut faire par rapport à la réalité. Les vrais positifs (VP) et les vrais négatifs (VN) sont deux de ces éléments.

Soit

La précision mesure la proportion de prédictions positives faites par le modèle qui étaient effectivement correctes, tandis que le rappel mesure la proportion d'exemples positifs réels qui ont été correctement identifiés par le modèle. Alors

Le F1-score est la moyenne harmonique de la précision et du rappel. Il fournit une mesure globale de la performance d'un modèle de classification, tenant compte à la fois de la précision et du rappel. Il est particulièrement utile lorsque les classes sont déséquilibrées.

Le F1-score tient compte à la fois des erreurs de type I (faux positifs) et des erreurs de type II (faux négatifs), fournissant ainsi une mesure équilibrée de la performance du modèle.

Le \(F_2\)-score est souvent utilisé dans des domaines où le rappel est considéré comme plus critique que la précision.

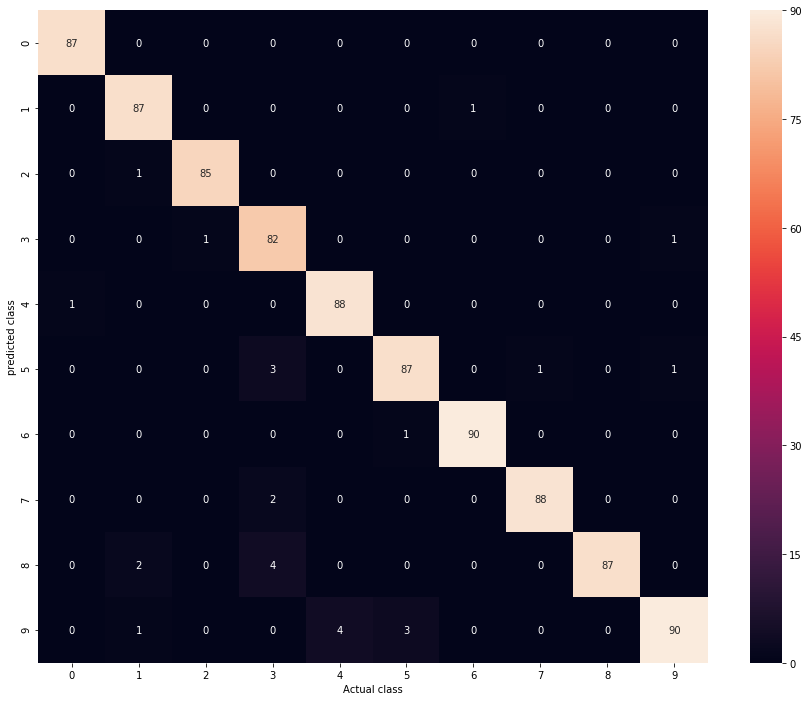

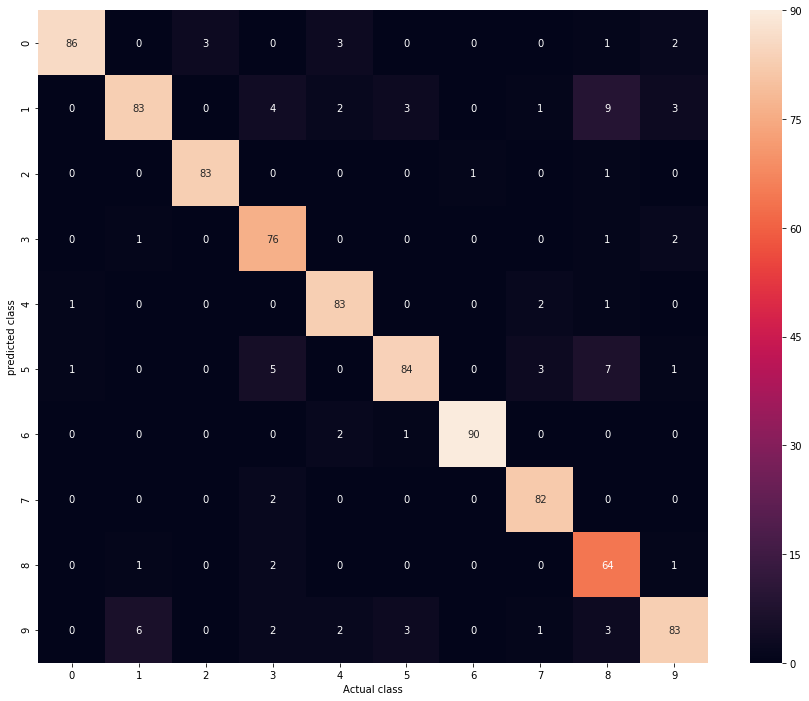

La matrice de confusion est un outil essentiel dans l'évaluation des performances d'un système de classification. Elle fournit une vue détaillée des prédictions faites par le modèle par rapport aux classes réelles.

Prendre des décisions signifie appliquer tous les classificateurs à un échantillon invisible x et prédire l'étiquette k pour laquelle le classificateur correspondant rapporte le score de confiance le plus élevé : \[\hat{y} = \underset{k \in \{1 \ldots K\}}{\arg\!\max}\; f_k(x)\]

\[ C_1.. ∪ ..C_k ∪ C_{outliers} = X \] et

\[ C_i ∩ C_j = ϕ, i ≠ j; 1 <i,j <k \]

\(C_{outliers}\) peut consister en des cas extrêmes (anomalie de données)

La régression linéaire est un modèle mathématique qui représente une relation linéaire entre une variable indépendante \(x_i\) et une variable dépendante \(y_i\). Le modèle a une forme d'une ligne droite (pour la régression linéaire simple) ou d'une parabole (pour la régression linéaire multiple).

Ligne droite: \(y_i = β_0 + β_1x_i + ε_i\) où \(β_0\) et \(β_1\) sont les coefficients de régression, \(x_i\) est la variable indépendante, et \(ε_i\) est l'erreur résiduelle.

Pour minimiser l'erreur :

L'objectif est de minimiser SSE pour obtenir la meilleure approximation de la relation linéaire entre les variables.

Processus consistant à attribuer une classe ou une étiquette à chaque élément d'une séquence de valeurs ou de tokens. Exemple : Reconnaissance d'entités nommées (NER) avec spaCy, où des entités comme les noms de personnes, les lieux, ou les organisations sont identifiées et étiquetées dans un texte.

| Balise | Signification |

|---|---|

| GPE | Pays, villes, états. |

| DATE | Dates ou périodes absolues ou relatives |

| CARDINAL | Les chiffres qui ne correspondent à aucun autre type. |

Les règles d'association, également connues sous le nom de "Association Rules", sont un ensemble de techniques d'analyse de données visant à découvrir les relations et les associations entre les variables dans un ensemble de données. Cette méthode recherche des corrélations et des co-occurrences entre les éléments, permettant ainsi de dégager des motifs ou des modèles significatifs.

Un exemple courant d'application des règles d'association est l'analyse de paniers d'achats dans le domaine du commerce de détail, où ces règles sont utilisées pour identifier des schémas d'achat, tels que les combinaisons de produits souvent achetés ensemble.

Prenons un exemple concret avec un tableau de données représentant les transactions d'une épicerie :

| Transaction | Produits achetés |

|---|---|

| 1 | Pain, Lait, Œufs |

| 2 | Pain, Beurre |

| 3 | Lait, Œufs, Fromage |

| 4 | Pain, Lait, Œufs, Bière |

| 5 | Lait, Bière, Chips |

Dans ce tableau, chaque colonne représente un produit et chaque ligne représente une transaction. Un "1" indique que le produit a été acheté lors de cette transaction, tandis qu'un "0" indique que le produit n'a pas été acheté.

| Transaction | Pain | Lait | Œufs | Beurre | Fromage | Bière | Chips |

|---|---|---|---|---|---|---|---|

| 1 | 1 | 1 | 1 | 0 | 0 | 0 | 0 |

| 2 | 1 | 0 | 0 | 1 | 0 | 0 | 0 |

| 3 | 0 | 1 | 1 | 0 | 1 | 0 | 0 |

| 4 | 1 | 1 | 1 | 0 | 0 | 1 | 0 |

| 5 | 0 | 1 | 0 | 0 | 0 | 1 | 1 |

Une règle d'association \(X ⇒ Y\) est valide si le support et la confiance de la règle dépassent les seuils spécifiés. Cela signifie que \(X\) et \(Y\) apparaissent fréquemment ensemble dans les transactions, et que lorsque \(X\) est présent, \(Y\) est également souvent présent.

Le support d'un ensemble d'articles dans le contexte des règles d'association est défini comme la fréquence à laquelle cet ensemble d'articles apparaît dans la base de données. En d'autres termes, c'est le nombre de transactions dans lesquelles cet ensemble d'articles est présent, divisé par le nombre total de transactions dans la base de données. Le support mesure donc la popularité ou la prévalence d'un ensemble d'articles. Il est utilisé pour évaluer à quel point une association entre deux ensembles d'articles est forte. Une valeur élevée de support indique que l'association est fréquente dans la base de données, ce qui la rend potentiellement plus significative.

\[supp(X) = \frac{|t ∈T; X ⊆ t|}{ |T|}\]

La confidence dans le contexte des règles d'association représente la fréquence à laquelle la règle a été trouvée vraie dans la base de données. Plus précisément, elle mesure la probabilité conditionnelle que la conséquence Y se produise dans une transaction, étant donné que l'antécédent X est également présent dans cette transaction.

La confidence d'une règle est calculée en divisant le nombre de transactions dans lesquelles à la fois X et Y sont présents par le nombre de transactions dans lesquelles X est présent. Ainsi, une confidence élevée indique que la conséquence Y est souvent vraie lorsque l'antécédent X est présent, ce qui renforce la fiabilité de la règle d'association.

\[conf(X ⇒ Y) = \frac{supp(X ∪ Y)}{supp(X)}\]

En utilisant les règles d'association, nous pouvons extraire des relations significatives entre les produits. Par exemple, en appliquant un support minimum de 40% et un seuil de confiance de 60%, nous pouvons identifier les règles d'association suivantes :

Cela signifie que dans 40% des transactions, les clients ont acheté du pain et du lait ensemble, et dans 100% de ces transactions, ils ont également acheté des œufs. De même, dans 60% des transactions, les clients ont acheté du lait, et dans 75% de ces transactions, ils ont également acheté des œufs.

Le lift dans le contexte des règles d'association est le rapport entre le "support" observé de la règle et celui attendu si les ensembles d'items X et Y étaient indépendants.Formellement, le lift est calculé en divisant le support de la règle par le produit des supports individuels de X et Y. En d'autres termes, c'est la mesure de combien plus fréquemment la règle est observée que ce à quoi on s'attendrait si les événements X et Y étaient indépendants.

Un lift supérieur à 1 indique que la règle a une association positive entre X et Y (c'est-à-dire que les items X et Y apparaissent ensemble plus fréquemment que prévu au hasard), tandis qu'un lift inférieur à 1 indique une association négative ou non significative. Un lift de 1 indique une indépendance entre les items X et Y.

La détection d'anomalies, également connue sous le nom de détection des valeurs aberrantes, implique l'identification de données inhabituelles ou divergentes dans un ensemble de données. Voici quelques approches courantes pour détecter les anomalies :

Des sursauts inattendus : Les anomalies peuvent se manifester sous forme de sursauts ou de pointes inattendues dans les données. Par exemple, une augmentation soudaine du trafic sur un site Web peut indiquer une attaque de déni de service (DDoS) dans le cas de la surveillance du trafic réseau, ou une augmentation anormale des transactions financières peut signaler une fraude.

Les caractéristiques des données varient selon le domaine d'application et les types spécifiques d'anomalies recherchées. Identifiez les schémas inhabituels ou les comportements aberrants dans les données peut aider à détecter les anomalies et à prendre des mesures appropriées pour les gérer.

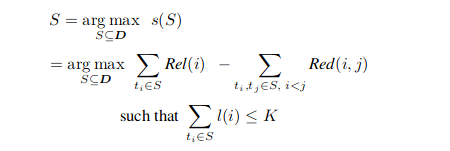

Trouver un sous-ensemble à partir de l'ensemble du sous-ensemble.

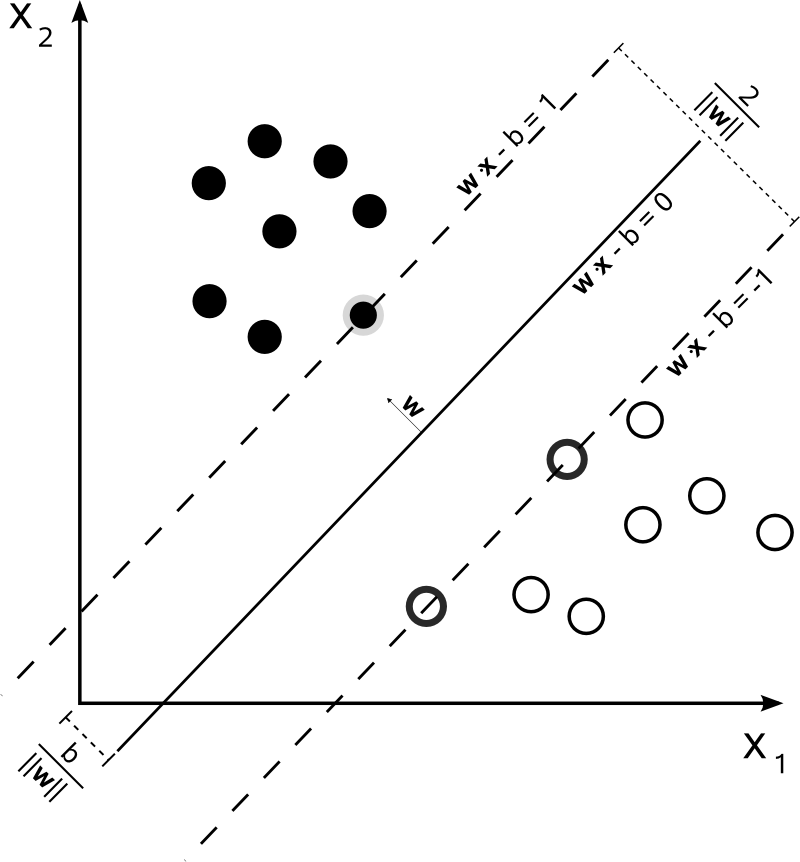

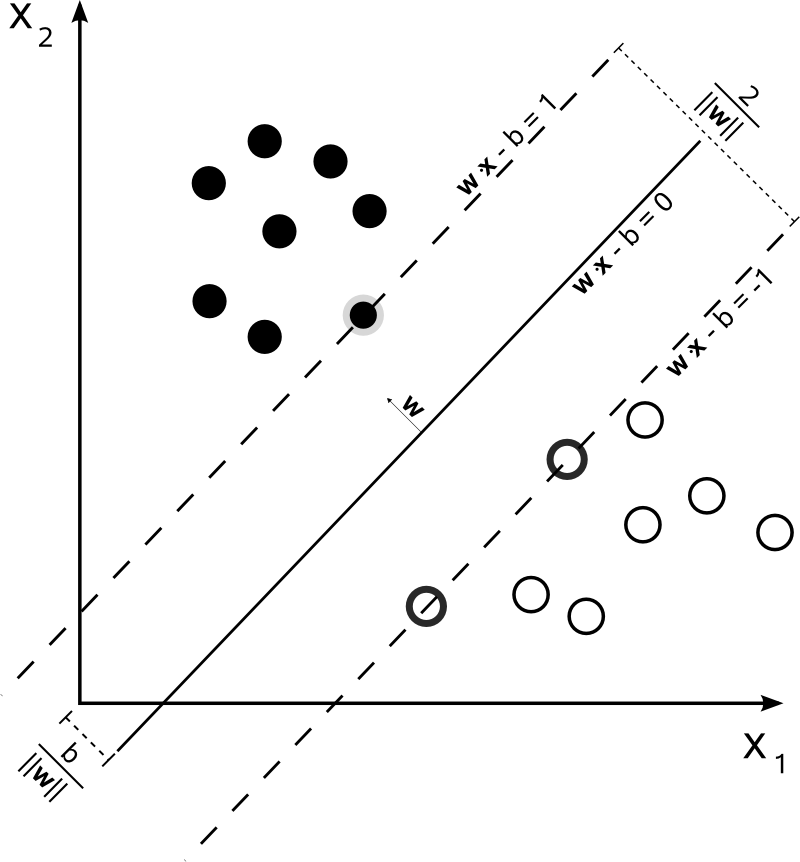

La machine à vecteurs de support (SVM) est une méthode d'apprentissage supervisé. SVM cherche à trouver la meilleure frontière de décision qui optimise la séparation des classes, ce qui permet une classification précise même dans des espaces de données complexes.

L'hyperplan dans l'espace n-dimensionnel est un sous-espace de dimension n-1 qui permet de séparer les données en deux classes.

Le gradient stochastique de descente est une technique d'optimisation utilisée pour minimiser une fonction objective qui peut être exprimée comme une somme de fonctions différenciables.

Le gradient est une généralisation multi-variable de la notion de dérivée.

| Dérivé | Gradient | |

|---|---|---|

| Définition | Taux de variation instantanée d'une fonction | Vecteur des dérivées partielles d'une fonction de plusieurs variables |

| Nombre de variables | Une seule | Plusieurs |

| Nature | Fonction scalaire | Fonction vectorielle |

| Représentation | Un seul nombre réel | Un vecteur de nombres réels |

| Utilisation | Fonctions d'une seule variable | Fonctions de plusieurs variables, notamment en optimisation et en machine learning |

| Géométrie | Pente de la tangente à un point d'une courbe | Direction et taux de variation le plus rapide d'une fonction dans un espace multi-dimensionnel |

L'algorithme du gradient stochastique de descente est un algorithme d'optimisation itératif largement utilisé pour trouver le minimum d'une fonction.

L'algorithme stochastique du gradient de descente est une variante où le gradient est calculé de manière stochastique, c'est-à-dire qu'au lieu d'utiliser l'ensemble complet des données pour calculer le gradient à chaque itération, un sous-ensemble aléatoire ou une seule observation est utilisé. Cela permet de gagner en efficacité, en particulier pour les grands ensembles de données.

L'objectif principal de cet algorithme est de minimiser une fonction objective, souvent une fonction de perte dans le cadre de l'apprentissage automatique, et il est largement utilisé dans des domaines tels que l'optimisation convexe, l'apprentissage automatique et le traitement du signal.

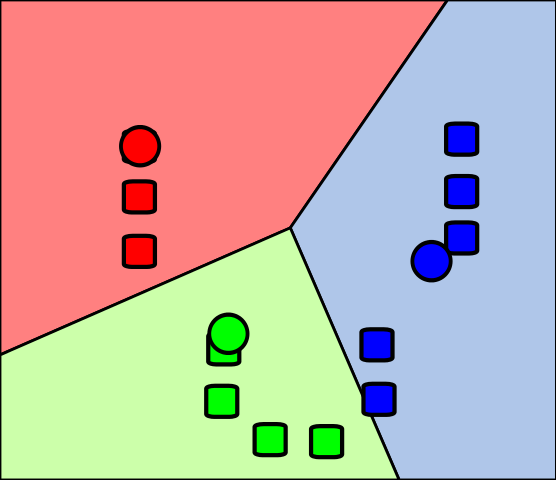

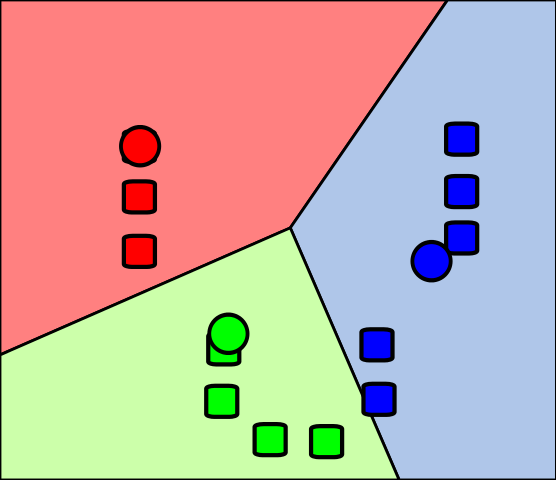

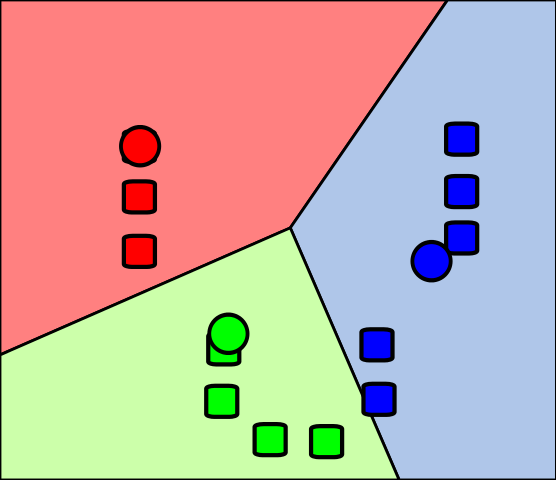

La méthode des k plus proches voisins (kNN) et le partitionnement en k-moyennes (k-means clustering) sont deux techniques importantes en apprentissage automatique et en exploration de données :

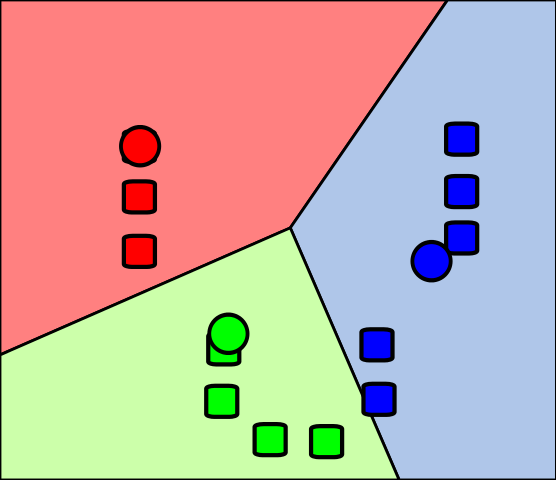

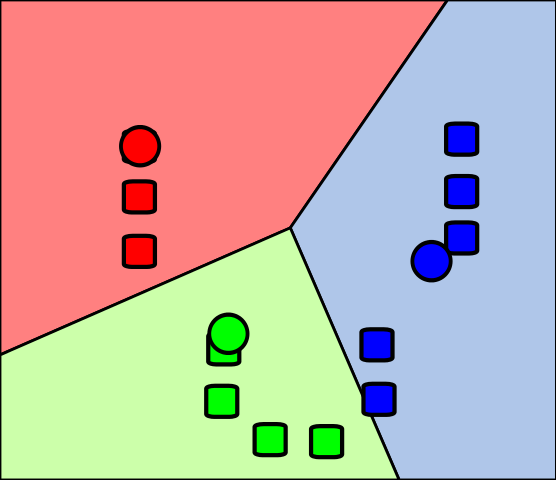

Les "moyens", également appelés centroïdes, sont les points initiaux autour desquels les clusters seront formés. Dans cette étape, k points sont sélectionnés de manière aléatoire à partir de l'ensemble de données pour servir de moyens initiaux.

Dans la deuxième étape de l'algorithme de partitionnement en k-moyennes (k-means clustering), également connue sous le nom d'étape d'affectation, les k clusters sont créés en associant chaque observation à la moyenne la plus proche.Les partitions représentent ici le diagramme de Voronoï généré par les moyennes.

Les centroids de chacun des k agrégats sont recalculés pour devenir les nouvelles moyennes.

La quatrième étape de l'algorithme de partitionnement en k-moyennes (k-means clustering) consiste à répéter les étapes 2 et 3 jusqu'à ce que la convergence soit atteinte.

La méthode des k plus proches voisins (k-NN) est un algorithme d'apprentissage supervisé utilisé à la fois pour la classification et la régression.

Supposons que nous ayons un ensemble de données d'apprentissage composé de points dans un espace bidimensionnel, où chaque point est associé à une classe. Supposons que nous voulions classer un nouveau point avec des coordonnées (x = 4, y = 3).

| Point | Coordonnée x | Coordonnée y | Classe |

|---|---|---|---|

| A | 2 | 3 | Rouge |

| B | 4 | 4 | Rouge |

| C | 3 | 2 | Bleu |

| D | 6 | 5 | Rouge |

| E | 5 | 3 | Bleu |

La classification naïve bayésienne est une méthode de classification probabiliste simple basée sur l'application du théorème de Bayes avec une forte hypothèse d'indépendance entre les caractéristiques.

\[P(A|B) = \frac{(P(B|A).P(A))}{P(B)}\]

\[P(S|W) = \frac{P(W|S) \cdot P(S)}{P(W|S) \cdot P(S) + P(W|H) \cdot P(H)}\]

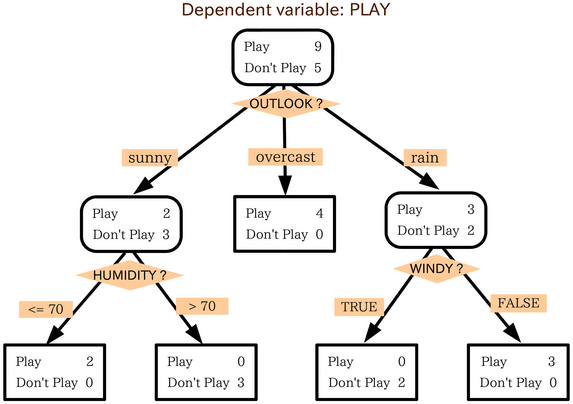

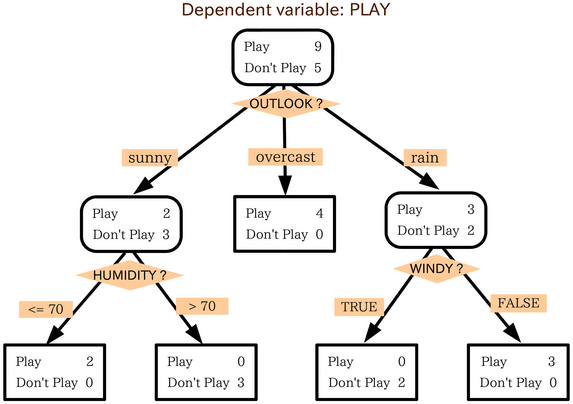

Les arbres de décision sont un outil puissant d'aide à la décision qui utilise un modèle arborescent pour représenter les décisions et leurs conséquences possibles

| Animal | Pelage | Plumes | Peut voler | Classe |

|---|---|---|---|---|

| Chien | Poilu | Non | Non | Mammifère |

| Chat | Poilu | Non | Non | Mammifère |

| Aigle | Plumeux | Oui | Oui | Oiseau |

| Pingouin | Plumeux | Oui | Non | Oiseau |

| Serpent | Écaille | Non | Non | Reptile |

Nous voulons classer ces animaux en trois classes : Mammifère, Oiseau ou Reptile. Utilisons un arbre de décision pour ce faire.

L'algorithme de l'arbre de décision est une méthode d'apprentissage supervisé utilisée pour la classification et la régression.

Dans le contexte des arbres de décision, les données sont généralement représentées sous forme de vecteurs où chaque élément du vecteur correspond à une caractéristique ou à une variable indépendante, et la variable dépendante est la cible que l'on cherche à prédire ou à classifier.

L'apprentissage ensembliste, en particulier les forêts d'arbres décisionnels, est une technique qui combine plusieurs modèles d'apprentissage pour améliorer les performances prédictives par rapport à un seul modèle. Les forêts d'arbres décisionnels sont obtenues en construisant de multiples arbres de décision lors de la phase d'entraînement.

La sélection de caractéristiques est un processus visant à choisir un sous-ensemble de caractéristiques pertinentes parmi un grand nombre de caractéristiques disponibles.